CourseraのMachine Learningのコースを完走できた。11週間くらいかかったけど、かなり効率良く機械学習について学べてとても良かった。

コースは機械学習の手法について広く教えてくれる。教師あり学習の線形回帰やロジスティック回帰、ニューラルネットワークの構築の仕方、教師なし学習のK-meansや主成分分析などなど。それだけでなく、実践的な技とか勘所を教えてくれるのが良い。例えば、大量の教師データを集める前に、データ増やして改善しそうな性質になっているかを確認して、半年とかを無駄にしないようにしましょうとか、まずはシンプルな手法に取り組んで様子をみながら難しい手法を試してみると良いでしょうとか。

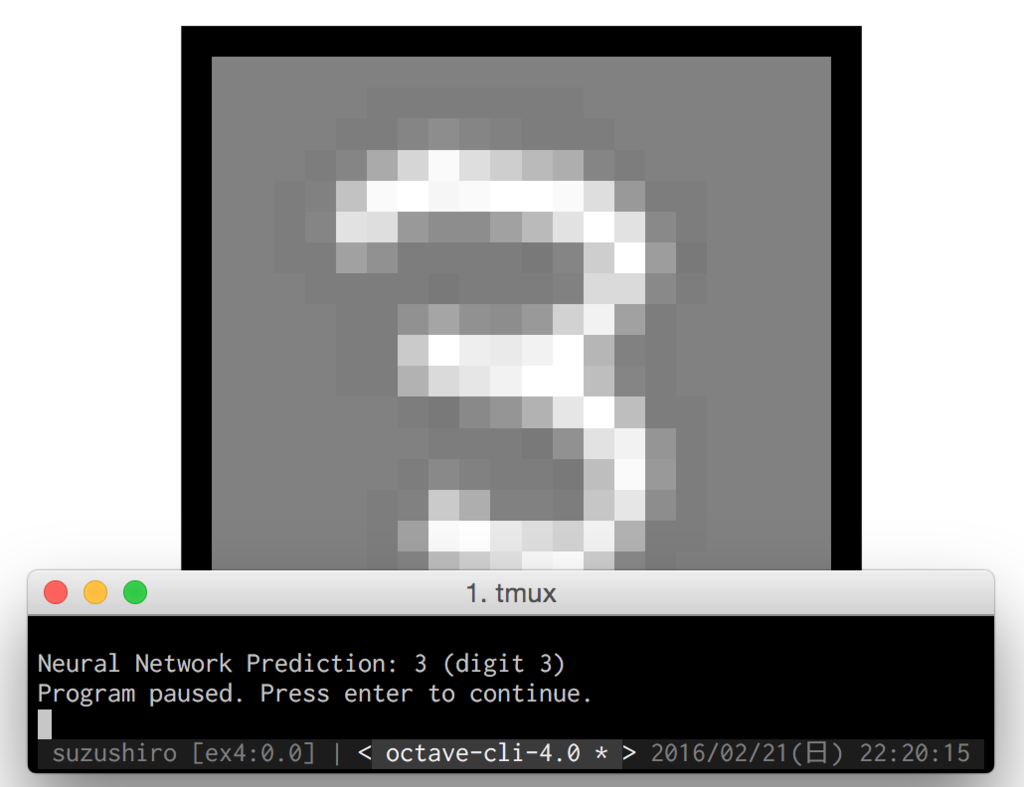

一週ごとに宿題があって理解を確認できるようになっている。宿題にはプログラミングの課題もあって、実際に機械学習のプログラミングの雰囲気を体験できる。単にアルゴリズムを実装するだけではなくて、グラフの様子をみながら改善していくといったフローになっていて自分でやるときも同じようにできそうで良い。簡単にはループで実装するところを、ベクトル化してシンプルな見た目、かつ高速に動作するように改良したりするのは、パズルっぽくておもしろかった(前もちょと書いてた)。

数学の知識がないと大変そうって思っていたものの、うろ覚えの基礎的な微分積分と線形代数でなんとかなった。とはいえ、手法の裏付けは数学的に証明されているので、できたらより納得感は高そう。もうちょっと理解したくて、微分積分勉強してる。微分積分は電子工学勉強するのにも使えるので便利そう。

11週間も時間を見つけてはビデオみたり、休みの日に宿題したりでちょっと忙しかった。しかし、機械学習分野のとっかかりを得るにはとても良くて、勉強して良かった。機械学習を使って自分で何か作ってみたりできそうだし、次に何を学ぶべきかもなんとなくわかる。何か役立つものを作ってみたい。

最後のビデオでは先生がそんな僕らに労いと感謝の言葉を繰り返し投げ掛けてくれて、涙なしでは見れないという感じでよかった。おすすめです。

俺が thank you と言いたい

— hakobe (@hakobe) April 8, 2016

あわせて読みたい: